Der Science-Fiction-Klassiker V: Relevanter denn je

Vor 40 Jahren feierte eine Serie Premiere, die Gesellschaft und Politik prägte. Faschistische Aliens und Fake News.

Bereits seit einigen Jahren beschäftige ich mich mit dem, was heute Generative AI genannt wird – insbesondere Text-to-Image-Generatoren aber auch Text-Generatoren. Diese Technologien basieren auf der Fähigkeit von künstlichen neuronalen Netzen, in vorhandenen Daten statistische Muster und Zusammenhänge zu erkennen und in einem Modell zu speichern. Basierend auf diesem kann ein System anschließend aus diesem Modell verschiedenste Inhalte generieren, die auf den Erlernten basieren. Beispielsweise Bilder, Texte oder sogar Videoinhalte.

Im Jahr 2022 kam es zu eine Revolution im Bereich der generativen KI. Ursache waren die sogenannten Transformer, eine Architektur von künstlichen neuronalen Netzen, die von Google Brain entwickelt wurde. Transformer sind auf die Verarbeitung von natürlicher Sprache spezialisiert. Sie können Texte als Gesamtheit betrachten und ihren Kontext erfassen, statt Worte wie an einem Fließband abzuarbeiten. Dabei ist Transformern möglich, wichtige Informationen in Texten mittels einer Art 'digitalen Aufmerksamkeit' zu gewichten.

Ein weiterer Durchbruch waren sogenannte Diffusionsmodelle. Hierbei ist es einer Künstlichen Intelligenz möglich auf einen beschreibenden Befehl hin – den sogenannten Prompt – ein Bild zu generieren. Das geschieht jedoch nicht, in dem einfach die gewünschten Bestandteile zusammengefügt werden. Stattdessen generiert ein Diffusionsmodell ein Rauschen, dem über sogenannte Schritte weiteres Rauschen hinzugefügt wird. Das KI-System versucht hierbei das Rauschen auf Basis statistischer Methoden und aus dem Modell abgerufenen Mustern jeweils so zu verändern, das es sich den verlangten Motiven annähert. Je mehr Schritte eine KI dabei gehen kann, um so detaillierter und präziser wird das Motiv.

Ich habe mich im Zuge des Erfolgs von ChatGPT mit verschiedenen Sprachmodellen – LLMs, large language models – wie der GPT-Familie, Llama, Alpaca und anderen befasst, habe so manches über Prompting gelernt und vor allem sehr, sehr viel Zeit mit dem generieren von Bildern in Stable Diffusion, DALLE 2/3 und Midjourney verschwendet.

Ich habe nach dem Erfolg von Midjourney, Stable Diffusion, Nano Banana, Minimax Image-01 und anderen Text-zu-Bild-Generatoren mit vielen Künstlern und Künstlerinnen gesprochen. Insbesondere darüber, wie diese neuen Technologien ihre Arbeit beeinflussen und sie diese in ihr Schaffen einbinden können.

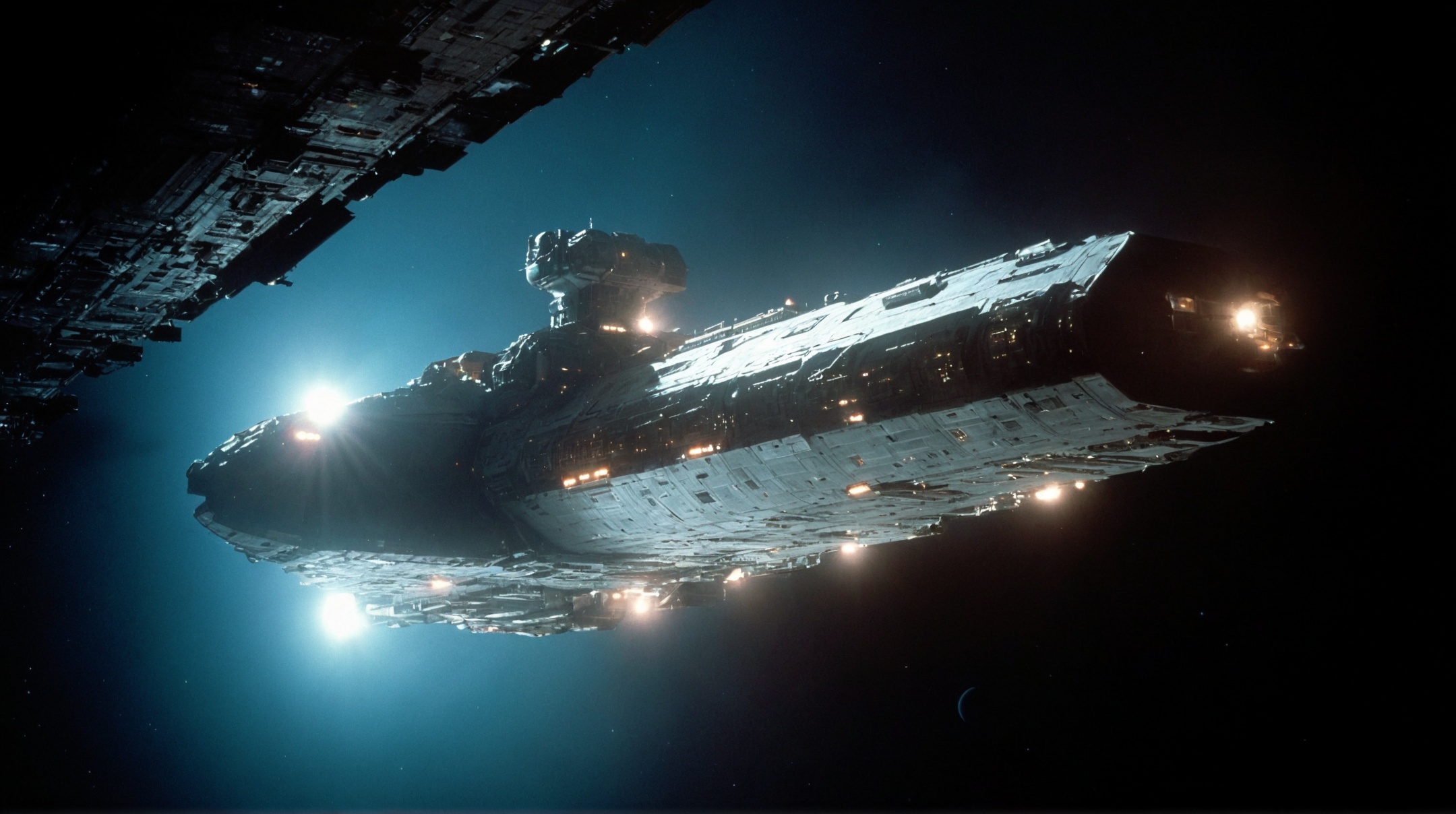

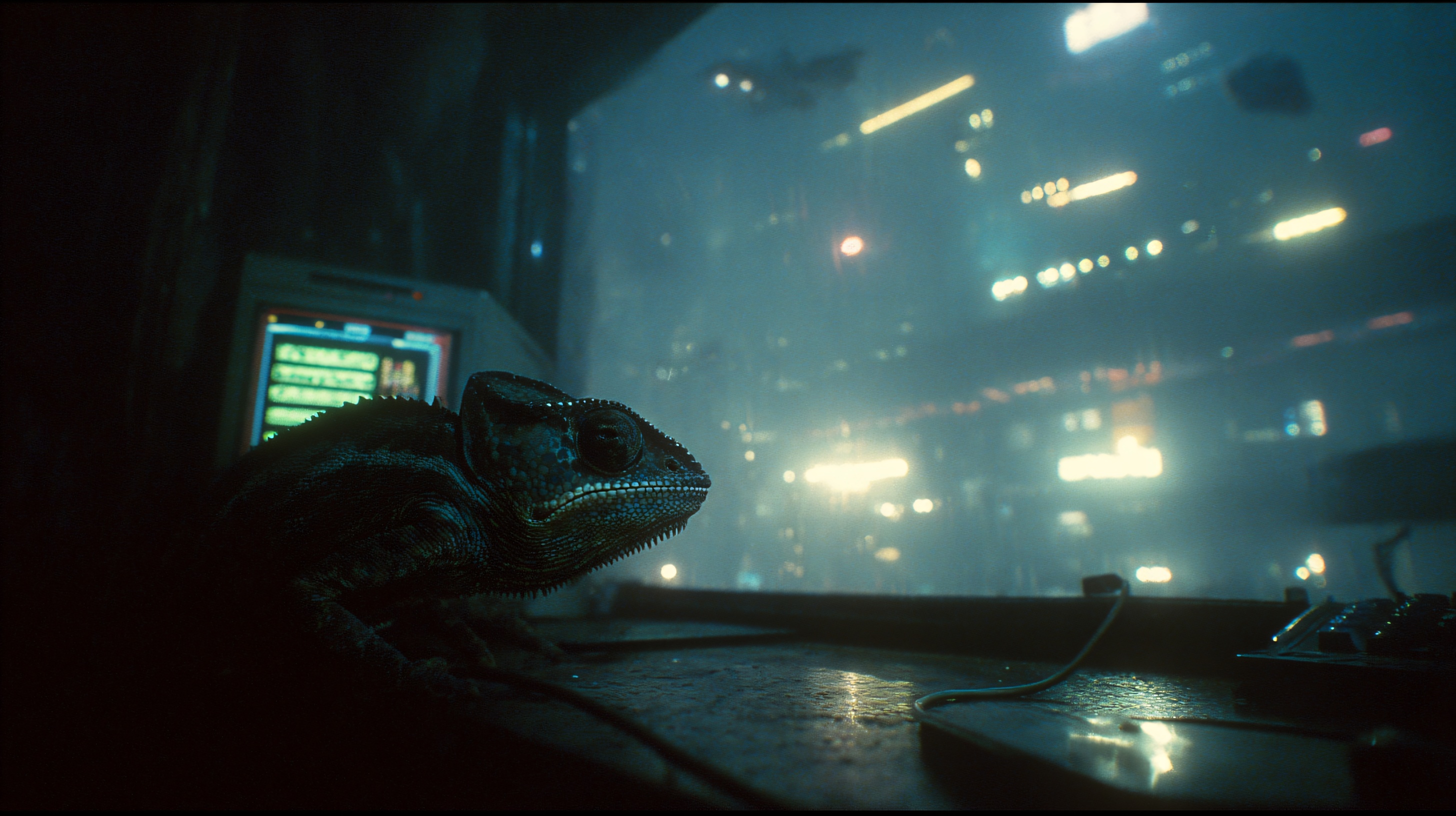

Vor allem rund um Stable Diffusion war (und bin ich) aktiv. Ich habe Modelle mit eigenen Inhalten und meiner Fotodatenbank nachtrainiert, um dem Modell bestimmte Stile beizubringen – insbesondere den einzigartigen Look von 80er-Jahre-Science-Fiction-Filmen.

Ebenso habe ich mit Stable Diffusion auf Anfrage hin für einen kleinen Videospielentwickler verschiedene Bilder generiert, die als Inspiration für ein Projekt dienen sollen, das eine surreale Post-Apokalpyse zeigt. Dazu bin ich immer wieder mit anderen Medienvertretern und Agenturen über diese neuen KI-basierten Tools im Austausch, um mit meinen Einschätzungen und Erfahrungen zu helfen. Oh, und manchmal sitze ich auch in Gesprächsrunden wie beispielsweise bei Webedia, wo ich meine Meinung vor kleinem Publikum teile.

Vor 40 Jahren feierte eine Serie Premiere, die Gesellschaft und Politik prägte. Faschistische Aliens und Fake News.

Er zweifelte an der Realität und glaubte an Simulationen. Über den Autor, der Matrix erst möglich machte.

Unser Redakteur wagte den Selbstversuch. Das Ergebnis überraschte auch ihn.

Von Robo-Hühnern und Schlapphüten. Die chaotische Entstehungsgeschichte des Kult-Shooters.

Wo kommt die Idee her – und was hat Nvidia damit zu tun?

Ein megalomanischer Plan aus den 70ern, um fremde Sonnensysteme zu erreichen.